- Müəllif Lynn Donovan [email protected].

- Public 2023-12-15 23:43.

- Son dəyişdirildi 2025-01-22 17:17.

Relu : Hesablamaq üçün hesablama baxımından daha səmərəlidir Sigmoiddən daha çox funksiyaları kimi Relu sadəcə mövzu max (0, x) lazımdır və Sigmoids kimi bahalı eksponensial əməliyyatlar yerinə yetirməyin. Relu : Təcrübədə, ilə şəbəkələr Relu göstərməyə meyllidirlər daha yaxşı konvergensiya performansı daha sigmoid.

Eynilə soruşa bilər ki, niyə ReLU ən yaxşı aktivləşdirmə funksiyasıdır?

Əsas fikir, gradientin sıfırdan fərqli olmasına icazə vermək və nəticədə məşq zamanı bərpa etməkdir. ReLu tanh və ilə müqayisədə daha az hesablama bahalıdır sigmoid çünki daha sadə riyazi əməliyyatları əhatə edir. Yəni a yaxşı dərin neyron şəbəkələri dizayn edərkən nəzərə alınmalı olan məqam.

Bir də soruşa bilərsiniz, sigmoid aktivləşdirmə funksiyası nədir? The sigmoid funksiyası a aktivləşdirmə funksiyası Neyron Şəbəkələrində Neyronların atəşə tutulması ilə əlaqəli şəkildə qurulmuş əsas qapı baxımından. Törəmə, həmçinin a tobe fəaliyyət göstərir aktivləşdirmə funksiyası Neyronla işləmək baxımından aktivləşdirmə NN baxımından. İkisi arasındakı fərq budur aktivləşdirmə dərəcə və qarşılıqlı əlaqə.

Eynilə, biz niyə CNN-də ReLU-dan istifadə edirik?

Konvolyusiya neyron şəbəkələri ( CNN ): Addım 1(b) - ReLU Qat. Düzəldilmiş Xətti Vahid və ya ReLU , edir konvolyusiya neyron şəbəkələri prosesinin ayrıca komponenti deyil. Düzəldici funksiyanın tətbiqinin məqsədi edir şəkillərimizdə qeyri-xəttiliyi artırmaq üçün.

ReLU-nun istifadəsi nədir?

ReLU (Düzeltilmiş Xətti Vahid) AktivləşdirməFunksiya ReLU ən çox istifadə olunur hazırda dünyada aktivasiya funksiyası. O vaxtdan belədir istifadə olunur demək olar ki, bütün konvolyusiya neyron şəbəkələrində və ya dərin öyrənmədə.

Tövsiyə:

Hansı telefon fotoqrafiya üçün daha yaxşıdır?

IPhone 11 Pro. Ən yaxşı nöqtə və kameralı telefon. Google Pixel 4. Ulduzları seyr edənlər üçün ən yaxşısı. Huawei P30 Pro. Ən yaxşı superzoom smartfonu. Xiaomi Mi Note 10. Dünyanın ən yüksək keyfiyyətli kameralı telefonu. Samsung Galaxy Note 10 Plus. Uzaqdan bağlanan S Pen ilə əla hərtərəfli cihaz. iPhone 11. Samsung Galaxy S10 Plus

Rəqəmsal media niyə daha yaxşıdır?

İndiki vaxtda istehlakçılar ən az çap qədər rəqəmsal mediaya məruz qalırlar. Marketinq və reklam üçün rəqəmsal medianın bir sıra üstünlükləri var. Çap mediasından daha ucuz ola bilər. Rəqəmsal çap da Çap mühitindən daha sürətli yenilənə bilər

Hindistanda hansı xalis sürət daha yaxşıdır?

Qlobal sürət testi şirkəti Ookla tərəfindən aparılan son araşdırmada Airtel orta sürəti 11,23 Mbit/s olan Hindistanın ən sürətli 4G şəbəkəsi olaraq ortaya çıxdı. Vodafone orta sürəti 9,13 Mbit/s olan ikinci ən sürətli 4G xidmət təminatçısı kimi çıxış edir

Hansı daha yaxşıdır Ryzen 3 və ya Intel i3?

Prosessorların müqayisəsi Nəzəri cəhətdən Ryzen 3 bu halda Intel Core i3-dən daha yaxşı performans göstərməlidir, çünki hər bir nüvənin CPU daxilində resurslarla rəqabət aparmasına ehtiyac yoxdur. Bununla belə, ən son Intel Skylake və Kaby Lake prosessorları daha üstün arxitektura ilə təchiz edilmişdir

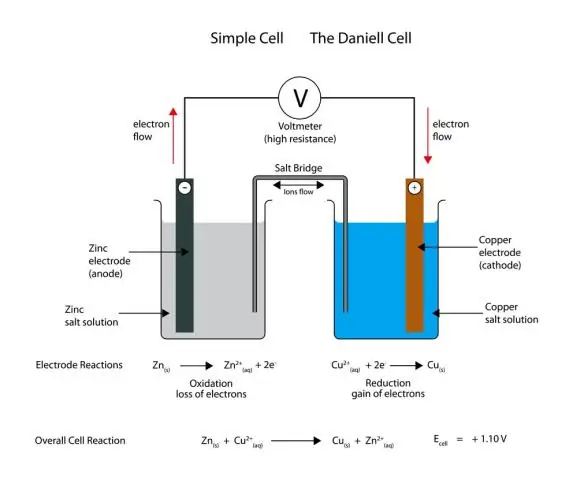

Batareyada daha çox hüceyrə daha yaxşıdır?

Bütün digər şeylər bərabərdirsə, daha çox hüceyrə daha yaxşıdır. Batareyada nə qədər çox hüceyrə varsa, hər batareyanın doldurulması daha uzun davam edəcək, buna görə də noutbukun bir batareyanın doldurulmasında “işləmə müddəti” bir o qədər uzun olacaq. Və eyni dərəcədə vacibdir, batareyanın özü ümumi olaraq daha uzun sürəcək